Het testen van elk onderdeel van je ‘marketing trechter’ zorgt altijd voor betere resultaten. We hebben het er hier al eerder over gehad. In plaats van nog meer praktijk, heb ik vandaag levensechte, concrete cijfers en voorbeelden voor je. Nog vers van de pers ook.

Eerder deze maand heb ik een marketingcampagne in gang gezet voor Systeemwebsites. Je weet wel: het merk waaronder we websites maken voor ondernemers die niet geïnteresseerd zijn in een website maar wel in resultaat. Een onderdeel van die online campagne is een banner campagne.

De banners hebben niet zozeer betrekking op SysteemWebsites. Via de banners wordt een (gratis) eBook aangeboden met de (veel te) lange titel “5 valkuilen die websitebouwers je wel eens vergeten te vertellen”.

Wat ik met deze campagne hoop te bereiken is dat mensen op de banner klikken, het eBook aanvragen en dat ik ze vervolgens via een serie e-mails (in een responder) kan overtuigen van het feit dat we bij SysteemWebsites de beste en meest effectieve websites ter wereld maken.

De banners zijn dus de eerste stap in de trechter waar ik nietsvermoedende ondernemers hoop ik te lokken 🙂

Er zijn tientallen verschillende banners te verzinnen om het (gratis) eBook via een banner te ‘verkopen’. De vraag is welke de meest effectieve is. Want ik ga adverteren. Dat kost geld. Dus ik ontdek graag welke banner het beste werkt.

Ik ben begonnen met twee verschillende banners:

Vanaf 15 november heb ik via een advertentienetwerk ‘spots’ gekocht. Ik richt me op ondernemers dus worden de banners geplaatst bij artikelen/content die gaan over ondernemen. De twee verschillende versies van de banner werden 50/50 geplaatst. Door die gelijkmatige rotatie krijg ik de meest betrouwbare data. Daar is in dit geval geen aanvullende software voor nodig. Die split test functie wordt standaard door het netwerk aangeboden.

Inmiddels zijn we 5 dagen verder. Hoogste tijd te kijken welke van de twee banners meer ondernemers aansprak? Welke kreeg de meeste klikken en bracht dus de meeste mensen naar mijn website?

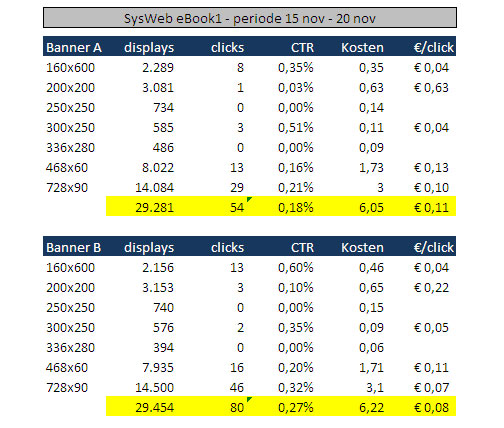

Hieronder zie je het resultaat:

Testen loont. Punt uit.

Banner B scoort ‘significant beter’ dan banner A. Met grofweg hetzelfde aantal vertoningen, brengt die banner bijna het dubbele aantal mensen naar mijn aanbod (54 tegenover 80 klikken).

Hoe betrouwbaar die conclusie is?

Een doorgestudeerde wiskundige flipt waarschijnlijk uit zijn panty bij deze conclusie. Die wil domweg meer cijfers om de statistische waarheid boven waarheid te krijgen. Maar als kleine ondernemer heb ik noch de tijd noch het budget om dit gevecht langer door te laten gaan. Ik moet verder, beslissingen nemen en knopen doorhakken.

Bovendien: als je de cijfers doorploegt, dan blijkt dat banner B in elk formaat beter scoort dan banner A. Dat lijkt een detail, maar is het niet. Het is een indicatie dat de cijfers betrouwbaar zijn. Als was gebleken dat de prestaties per formaat niet parallel lopen, dan had ik de campagne langer laten doorlopen om meer betrouwbare cijfers te krijgen.

Bij ernstige twijfel kan een ABB test helpen. Je zet dan de (waarschijnlijke) verliezer af tegen twee versie van de (waarschijnlijke) winnaar. Als beide winnaars beter scoren dan banner A dan kun je er met ‘aan zekerheiod grenzende waarschijnlijkheid’ vanuit gaan dat banner B je meer omzet, klanten, leads, optins, leden of wat dan ook oplevert.

Waarom B beter scoort dan A?

Wie het (zeker) weet mag het zeggen. Duidelijk is dat de ’toon’ van de kopregel anders is en blijkbaar bij meer ondernemers een snaar raakt. Of de ‘buttpon’ in de ene en de blauwe link in de andere banner verschil maakt is lastiger. Om daar achter te komen zou je meer moeten testen: banner B met een knop versus de huidige banner.

Is een CTR van 0,27% acceptabel?

De CTR van de winnaar valt me niet tegen. Ik hoop uiteraard dat de nieuwe uitdager deze gaat overtreffen, maar voor een redelijk breed uitgezette banner campagne zoals deze heb ik slechtere resultaten gezien. Geen man overboord dus.

En hoe nu verder?

Banner A gaat naar het rusthuis voor kreupele banners. Daarvoor in de plaats komt banner C. Dat is de nieuwe ‘uitdager’ voor banner B. Over een dag of 5 trekken we opnieuw de cijfers in een spreadsheet en kijken we wie de nieuwe winnaar is. De verliezer valt opnieuw af en banner D wordt de nieuwe uitdager. Enzovoorts, enzovoorts. Net zo lang tot ik op een punt kom dat er geen zichtbaar verschil meer ontstaat tussen de ‘winnaar’ en de ‘uitdager’. Soms is dat na een banner of 4, soms zijn er meer dan 10 nodig voor je dat 100% geoptimaliseerde resultaat bereikt.

Niet alleen banner testen

Marketing online is hard werken. De bannercampagne is niet het enige onderdeel van deze campagne dat wordt getest. Ook de landingspagina wordt ge-split-test. Op dezelfde manier: versie A tegenover versie B en zodra de cijfers een beetje volume hebben wordt de verliezer koel en gewetenloos vervangen door een nieuwe uitdager. Tegelijkertijd worden de e-mails in de autoresponder getest: het onderwerp, de eerste alinea, de ‘call to action’ in de laatste alinea – en ga zo maar door. Letterlijk. Want aan testen komt nooit een einde.

Aan dit artikel wel. Prettige dag verder 🙂

Over Carl Weenink

Stapte van 'sales' naar de journalistiek, werd 'ghostwriter', maakte bladen, verzeilde in de reclame, raakte verslaafd aan Direct Marketing en bundelde gaandeweg de ideale combinatie van commercie, content en marketing tot een solide fundament onder wat we 'online marketing' noemen. Meer >>"

Geef een antwoord